Luna ha solo 21 mesi, ma sta già contribuendo a svelare i misteri dell’apprendimento umano e a migliorare l’intelligenza artificiale. Ogni settimana, per un’ora, suo padre Brenden Lake, psicologo alla New York University, le mette un cappellino con una telecamera e registra il mondo dal suo punto di vista mentre gioca. L’obiettivo? Usare questi video per addestrare un modello di linguaggio, una “LunaBot”, con gli stessi input sensoriali a cui è esposta una bimba.

Attraverso questo innovativo progetto, Lake e la sua compagna, Tammy Kwan, sperano di creare strumenti migliori per comprendere sia l’AI che noi stessi.

Le sfide dell’apprendimento del linguaggio nei bambini

L’acquisizione del linguaggio nei bambini è un processo complesso, che ha affascinato scienziati e ricercatori per decenni. In pochissimo tempo i neonati passano dall’essere dei veri e propri “blob sensoriali” a comunicatori mobili, razionali e attenti. Come fanno?

Alcuni scienziati sostengono che la maggior parte dell’apprendimento del linguaggio possa essere spiegata attraverso l’associazione, in modo simile a come i cani associano il suono di una campana al cibo. Poi ce ne sono altri per cui esistono caratteristiche innate nella mente umana che modellano le forme di ogni lingua e sono cruciali per il nostro apprendimento. Altri ancora ritengono che i bambini costruiscano la comprensione di nuove parole sulla base della loro comprensione di altre parole.

Il progetto di Brenden Lake, Tammy Kwan e la loro bimba mira a far luce su queste questioni, creando un ponte tra l’intelligenza umana e quella artificiale.

Una bimba come coach: LunaBot

Ogni domenica mattina, per un’ora, Lake mette un cappellino con una telecamera a Luna e registra il mondo dal suo punto di vista mentre gioca. L’obiettivo è utilizzare i video “diretti” dalla sua bimba per addestrare un modello di linguaggio, chiamato LunaBot, con gli stessi input sensoriali a cui è esposta una bambina di quell’età.

In questo modo, i ricercatori sperano di creare strumenti migliori per comprendere sia l’AI che noi stessi. “Vediamo questa ricerca come un modo per creare finalmente quel collegamento tra queste due aree di studio”, ha dichiarato Lake. “Puoi finalmente metterle in dialogo tra loro”.

Per un’ora ogni settimana negli ultimi 11 mesi, Brenden Lake, psicologo della New York University, qui con sua moglie Tammy Kwan, ha attaccato una telecamera al cappellino della sua bimba, Luna, e ha registrato le cose dal suo punto di vista. Foto: Hiroko Masuike/New York Times

Le differenze tra mente umana e modelli di AI

Ci sono molti ostacoli nell’utilizzare i modelli di AI per comprendere la mente umana. Perché, checché ne dica qualcuno, sono modelli profondamente diversi.

I moderni modelli di linguaggio e multimodali, come GPT-4 di OpenAI e Gemini di Google, sono costruiti su reti neurali con poca struttura predefinita e sono migliorati principalmente grazie all’aumento della potenza di calcolo e a set di dati di addestramento più grandi. L’ultimo grande modello di linguaggio di Meta, Llama 3, è addestrato su più di dieci trilioni di parole.

Un bimbo o una bimba di cinque anni sono esposti a circa 300.000 parole. Ma non è solo questo.

E poi c’è tutto il resto della realtà, quella che va oltre le parole. C’è il mondo, altroché. I modelli AI possono analizzare i pixel nelle immagini, ma non sono in grado di assaggiare il formaggio o le bacche o di sentire la fame, esperienze di apprendimento fondamentali per gli esseri umani.

I ricercatori possono fare del loro meglio per trasformare l’intero flusso sensoriale di un bambino in codice, ma aspetti cruciali della loro fenomenologia andranno inevitabilmente persi. Anche l’embodiment, che aumenterà a dismisura le potenzialità dell’intelligenza artificiale, e ci fornirà probabilmente robot androidi di massa, non coprirà mai questo gap.

L’intenzionalità umana e i limiti dei modelli di AI

Un’altra differenza fondamentale tra la mente umana e i modelli di AI è l’intenzionalità. Gli esseri umani non sono semplici “spugne di dati”, come le reti neurali, ma animali intenzionali.

Tutto ciò che vediamo, ogni oggetto che tocchiamo, ogni parola che sentiamo si accoppia con le credenze e i desideri che abbiamo in quel momento.

C’è una profonda relazione tra ciò che stai cercando di imparare e i dati che entrano. Questi modelli si limitano a predire. Prendono qualsiasi cosa venga messa in loro e fanno il passo successivo migliore.

Linda Smith, psicologa dell’Indiana University

Il dottor Lake con Wai Keen Vong (a sinistra), un ricercatore della New York University che ha contribuito a condurre il lavoro, e Wentao Wang (a destra), un dottorando. Foto: Hiroko Masuike/New York Times

Dai video di una bimba a una migliore comprensione dell’intelligenza umana e artificiale

Delle differenze vi ho parlato. Sono quelle che marcheranno per sempre (o molto a lungo) una distanza tra noi e le macchine. Ciò detto, il progetto di Lake e Kwan rappresenta comunque un passo importante verso una migliore comprensione dell’intelligenza artificiale, e pure di quella umana.

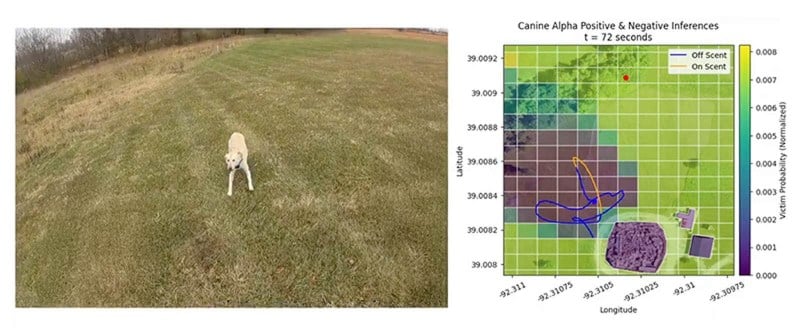

A febbraio, Lake e i suoi collaboratori hanno creato un primo modello di AI addestrato su video realizzati nel laboratorio di Michael Frank a Stanford più di un decennio fa. Il modello, pubblicato sulla rivista Science, è stato in grado di associare diversi momenti a parole basandosi su 60 ore di filmati.

Sono risultati sbalorditivi. Suggeriscono che potrebbe essere possibile per il linguaggio essere appreso principalmente attraverso l’associazione. E ora?

Quanto possiamo rendere “umana” l’AI? Come possiamo insegnarle interazioni sociali, intenzioni e pregiudizi, raccogliendo filmati completi da una telecamera montata sulla testa di una bimba di un anno? È una domanda dal fascino incredibile.

Se arriveremo al punto in cui i modelli sono addestrati solo sui dati di un singolo bambino, e ottengono buoni risultati su un enorme insieme di compiti, sarà un enorme risultato scientifico.

E poi c’è lei. Luna. La bimba.

Mentre Luna e suo fratello maggiore Logan si preparavano per una festa di compleanno, Lake ha interrotto la registrazione sulla telecamera della bimba e le ha dato un paio di morbidi guanti bianchi con disegnato il musetto di una pecorella. “Cosa sono quelli, Luna?” ha chiesto. “Bee, bee”, ha risposto Luna.

Diamo per scontati i processi dietro una risposta del genere (a parte l’immensa dolcezza). Sono processi profondi e non del tutto comprensibili, in realtà. Processi che rendono una bimba così piccola infinitamente più potente di qualsiasi intelligenza artificiale sia mai stata sviluppata.

Compresa la prossima, che farà un altro passo avanti proprio grazie a lei.

L’articolo LunaBot: l’AI addestrata con gli occhi di una bimba di 21 mesi è tratto da Futuro Prossimo.

Tecnologia, intelligenza artificiale