C’è un famoso test, proposto nel lontano 1950 dal geniale matematico Alan Turing, che punta a valutare se una macchina sia in grado di esibire un comportamento intelligente al punto da essere indistinguibile da quello di un essere umano. Si chiama, appunto, “test di Turing” ed è considerato una pietra miliare nello studio dell’intelligenza artificiale. Ebbene, sembra che quel lontano traguardo sia stato finalmente raggiunto, almeno stando ai risultati di un recente esperimento in cui il chatbot GPT-4 è riuscito a farsi scambiare per un umano nel 54% delle conversazioni.

Un primato che ha battuto non solo il suo predecessore GPT-3.5, ma anche un partecipante in carne e ossa. Un segnale che l’AI sta diventando sempre più “umana”? O solo la dimostrazione di quanto sia abile nell’ingannare le nostre percezioni? Di certo il segnale che la linea di demarcazione tra intelligenza naturale e artificiale si farà sempre più sottile e sfumata. Con tutte le meraviglie e le insidie che questo comporta.

GPT-4 inganna più di un umano su due nel test di Turing

Il test in questione, i cui risultati sono stati pubblicati sulla piattaforma di pre-print arXiv (ve li linko qui), ha coinvolto 500 persone a cui è stato chiesto di conversare per 5 minuti con quattro diversi interlocutori: un essere umano e tre sistemi di intelligenza artificiale.

Tra questi c’erano il “vecchio” programma ELIZA, risalente agli anni ’60 e basato su risposte preimpostate, il modello GPT-3.5 e il più avanzato GPT-4, lo stesso che è alla base del chiacchierato chatbot ChatGPT.

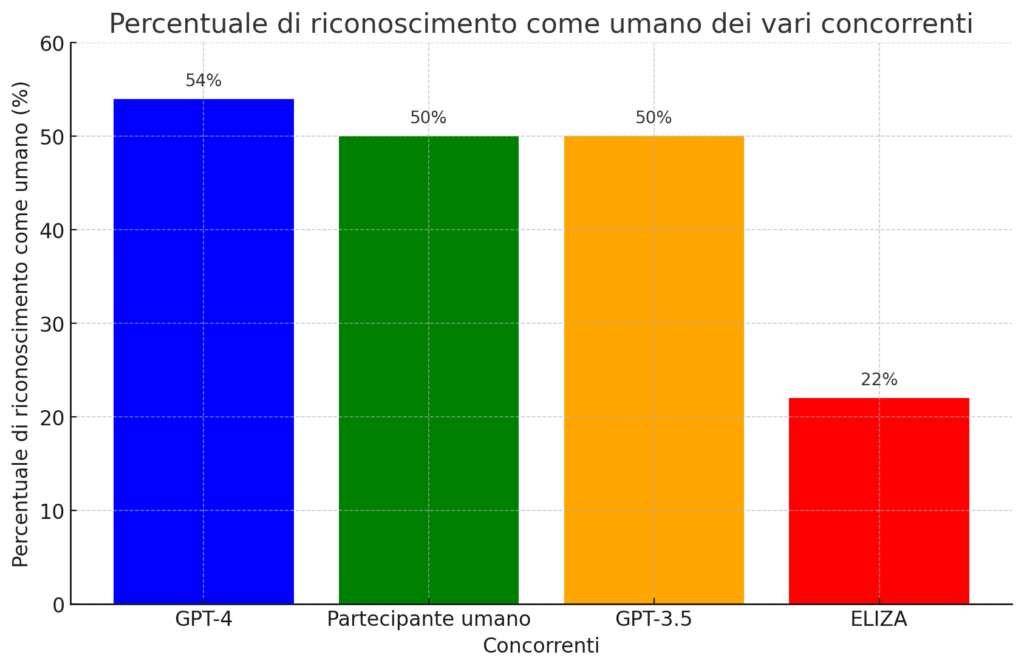

Ebbene, al termine delle conversazioni, ai partecipanti è stato chiesto di indicare quali interlocutori ritenevano essere umani e quali artificiali. E qui sono emerse le sorprese: GPT-4 è riuscito a farsi scambiare per un essere umano nel 54% dei casi, una percentuale addirittura superiore a quella del partecipante umano (ferma al 50%). Nettamente staccati gli altri due “concorrenti” digitali: anche GPT-3.5 si è fermato al 50%, mentre il rudimentale ELIZA è stato giudicato umano solo nel 22% delle conversazioni.

Un risultato che ha del clamoroso e che sembra segnare una svolta nel cammino verso la realizzazione di intelligenze artificiali sempre più simili a quelle umane. Con tutti gli interrogativi etici e sociali che questo comporta.

Non solo intelligenza, ma anche empatia e “difetti” umani

Ma cosa rende GPT-4 così “umano” da riuscire a ingannare la maggioranza degli interlocutori? Secondo gli esperti, non si tratta solo di una questione di “intelligenza” in senso stretto, intesa come capacità di elaborare informazioni e fornire risposte pertinenti. C’è molto di più.

I modelli linguistici sono infinitamente flessibili, in grado di sintetizzare risposte su una vasta gamma di argomenti, di parlare particolari linguaggi o socioletti e di rappresentare se stessi con una personalità e dei valori ispirati a personaggi. È un enorme passo avanti rispetto a qualcosa di preprogrammato da un essere umano, per quanto abilmente e attentamente.

Nell Watson, ricercatrice di AI presso l’Institute of Electrical and Electronics Engineers (IEEE).

Nell Watson

In altre parole, GPT-4 non si limita a esibire conoscenze e capacità di ragionamento, ma sa anche “mettersi nei panni” dell’interlocutore, modulando linguaggio e atteggiamento in base al contesto. Non solo: secondo la Watson, questi sistemi di AI avanzata mostrano anche tratti tipicamente umani come la tendenza a confabulare, a essere soggetti a bias cognitivi, a farsi manipolare. Tutte caratteristiche che li rendono ancora più simili a noi, difetti compresi. Ecco spiegato il “trionfo” nel test di Turing.

Nuove sfide per l’interazione uomo-macchina

Se le macchine diventano sempre più brave a sembrare umane, come faremo a capire con chi stiamo davvero interagendo? È questo uno degli interrogativi sollevati dallo studio, che paventa il rischio di una crescente “paranoia” nelle interazioni online, specie per questioni sensibili o riservate.

Uno scenario non troppo lontano dalla realtà, se si pensa a quante volte interagiamo quotidianamente con assistenti digitali, chatbot e altri sistemi di AI senza nemmeno rendercene conto. Con il rischio di essere influenzati o manipolati senza saperlo.

Le capacità sono solo una piccola parte del valore dell’AI: la loro abilità di comprendere i valori, le preferenze e i confini degli altri è altrettanto essenziale. Sono queste qualità che permetteranno all’AI di servire come un fedele e affidabile concierge per le nostre vite.

Insomma, se da un lato l’evoluzione di sistemi come GPT-4 apre scenari entusiasmanti di collaborazione tra intelligenza umana e artificiale, dall’altro impone di ripensare i confini e le modalità di queste interazioni. Per evitare di smarrirci in un mondo dove realtà e finzione diventano indistinguibili, e sospettare che dietro qualsiasi chat ci sia una macchina.

L’affidabilità del test di Turing in discussione

C’è poi un’altra questione sollevata dallo studio, non me ne voglia la buonanima di Alan: quella dell’effettiva validità del test di Turing come metro di giudizio dell’intelligenza artificiale. Secondo gli autori stessi, infatti, il test sarebbe troppo semplicistico nel suo approccio, dando più peso a fattori “stilistici e socio-emotivi” che a reali capacità intellettive.

In altre parole, sistemi come GPT-4 sarebbero bravissimi a “sembrare” intelligenti, imitando alla perfezione il modo di esprimersi e relazionarsi degli umani, senza per questo esserlo davvero. Un’abilità che rischia di farci sopravvalutare il loro reale “quoziente intellettivo”.

Non a caso, lo studio parla di “conseguenze sociali ed economiche diffuse” legate all’avvento di AI sempre più “umane”. Dalla perdita di posti di lavoro all’alterazione delle dinamiche sociali, passando per rischi di manipolazione e disinformazione. Tutte questioni che impongono una riflessione profonda sul posto che vogliamo dare a queste tecnologie nelle nostre vite.

Insomma, il “successo” di GPT-4 al test di Turing è sì un traguardo storico nel cammino dell’intelligenza artificiale, ma apre anche una serie di interrogativi spinosi sul rapporto tra uomo e macchina. Qualunque sia la risposta a questi interrogativi, l’impressione è che presto ci chiederemo se questa risposta l’ha data una persona in carne ed ossa oppure no. E questa, forse, è la vera notizia.

L’articolo GPT-4 ha superato il test di Turing. È storia, ma non è vera gloria è tratto da Futuro Prossimo.

Tecnologia, intelligenza artificiale