Il futuro, cantava Enrico Ruggeri, è un’ipotesi. E in questa ipotesi c’è anche un’intelligenza artificiale in grado non solo di battere l’uomo a scacchi o a Go, ma di scrivere romanzi, comporre sinfonie. Fare scoperte scientifiche, perfino provare emozioni. È il miraggio dell’intelligenza artificiale generale, o AGI: sistemi con capacità cognitive generali simili e superiori a quelle umane. Un traguardo che sembra avvicinarsi grazie ai modelli linguistici avanzati come GPT-4 e ora anche ol. Ma i nodi teorici e pratici da sciogliere sono ancora tanti.

Il sogno dell’AGI

Da decenni, l’intelligenza artificiale generale (AGI) è l’Eldorado, la terra promessa dei ricercatori di intelligenza artificiale. L’idea di creare una macchina in grado di eguagliare e superare le capacità cognitive umane in tutti i campi (dal ragionamento astratto alla creatività, dalla pianificazione alla generalizzazione delle competenze) affascina e insieme spaventa.

Un sistema di AGI sarebbe infatti in grado di risolvere in autonomia problemi estremamente complessi come il cambiamento climatico, le future pandemie, trovare cure per malattie devastanti come il cancro e l’Alzheimer. Potrebbe far progredire la scienza e la tecnologia a un ritmo senza precedenti, rivoluzionando settori come l’esplorazione spaziale, l’energia pulita, i trasporti, l’istruzione.

D’altro canto, una super intelligenza artificiale generale avrebbe un potere enorme e potenzialmente incontrollabile se non adeguatamente allineata ai valori umani. “Potrebbero accadere cose terribili a causa dell’uso improprio dell’IA o perché ne perdiamo il controllo”, avverte Yoshua Bengio, uno dei padri del deep learning e pioniere della ricerca sull’AGI. Scenari apocalittici che riecheggiano quelli immaginati da scienziati del calibro di Stephen Hawking e imprenditori visionari come Elon Musk.

AlphaGo e i limiti degli attuali sistemi di IA

Fino a pochi anni fa, l’AGI sembrava un miraggio lontano. I progressi nell’intelligenza artificiale “ristretta” erano impressionanti ma limitati a compiti specifici. Si pensi ad esempio ad AlphaGo, il sistema di IA sviluppato da Google DeepMind in grado di battere i campioni mondiali del gioco da tavolo Go. Un risultato storico, che però non rende AlphaGo intelligente in senso generale: sa solo giocare a Go, non può improvvisarsi scrittore, compositore o scienziato.

È il limite degli attuali sistemi di IA, anche i più avanzati: sono “sapienti idioti”, estremamente bravi in un dominio ristretto (che sia giocare a scacchi, riconoscere immagini o generare testo) ma incapaci di trasferire quelle competenze ad ambiti diversi. Manca loro quella capacità di generalizzare e astrarre, che è la cifra dell’intelligenza umana.

La rivoluzione dei modelli linguistici

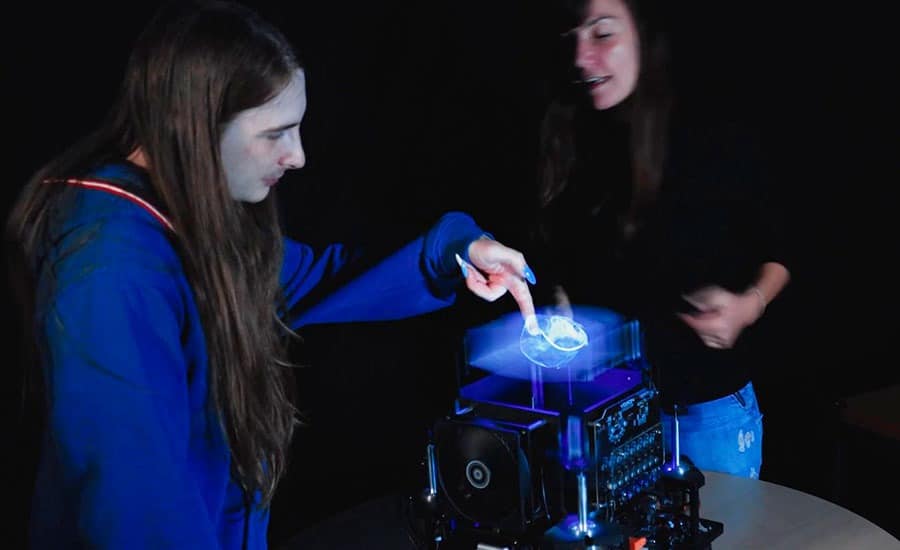

La recente rivoluzione dei modelli linguistici come GPT-3 di OpenAI, LaMDA di Google, DALL-E (sempre di OpenAI), Stable Diffusion di Stability AI, per citare i più noti, ha cambiato le carte in tavola. O meglio, ci ha mostrato una rappresentazione di come sarebbe una intelligenza artificiale generale più vicina di quanto si pensasse fino a poco tempo fa.

La caratteristica che rende così promettenti questi modelli è la loro polifunzionalità: a differenza dei sistemi di IA “ristretta”, sono in grado di affrontare compiti molto diversi tra loro, dalla scrittura di testi alla generazione di immagini, dalla conversazione alla soluzione di problemi, con risultati spesso impressionanti.

Una polifunzionalità che ricorda per certi versi quella della mente umana e ha fatto parlare alcuni ricercatori di “intelligenza artificiale generale già raggiunta”. In particolare, il recente annuncio di ol, l’ultimo modello di OpenAI, che (in alcuni casi, pochi per la verità) vanterebbe capacità di ragionamento e di apprendimento molto più simili a quelle umane rispetto ai suoi predecessori, ha riacceso il dibattito.

I nodi da sciogliere verso l’intelligenza artificiale generale

Come sottolinea François Chollet, informatico e creatore del framework per l’IA Keras, i grandi modelli linguistici attuali soffrono ancora di grossi limiti che li rendono “non sufficienti per arrivare all’AGI”.

Uno dei problemi principali è la generalizzazione: sebbene allenati su enormi quantità di dati (si parla di terabyte di testo e immagini), questi sistemi faticano ad applicare ciò che hanno imparato a situazioni anche solo leggermente diverse da quelle su cui sono stati addestrati. “I modelli linguistici non possono veramente adattarsi alla novità perché non hanno la capacità di ricombinare le loro conoscenze al volo per adattarsi a nuovi contesti”, spiega Chollet.

Collegata alla generalizzazione è anche la nozione di “apprendimento da pochi esempi” (few-shot learning), una delle caratteristiche cardine dell’intelligenza umana. Ad oggi, i modelli linguistici richiedono una mole enorme di dati e un riaddestramento costoso per “imparare” nuovi compiti, mentre noi esseri umani siamo spesso in grado di cogliere un concetto da uno o pochissimi esempi.

Le strade impossibili verso l’intelligenza artificiale generale

Come dimostrano alcuni esperimenti, le “rappresentazioni interne” che i modelli linguistici costruiscono della realtà sono spesso superficiali e incoerenti. Ad esempio, un team di ricercatori di Harvard ha addestrato un modello sui percorsi dei taxi nella città di New York, riuscendo a fargli prevedere con grande precisione la destinazione dato il punto di partenza. Osservando le “mappe mentali” sviluppate dal sistema, però, i ricercatori hanno scoperto che erano completamente senza senso, “con strade dall’orientamento fisicamente impossibile e cavalcavia che passano sopra altre strade”.

Infine, manca ancora nei modelli attuali un meccanismo di feedback come quello presente nel cervello umano, dove le informazioni fluiscono in modo bidirezionale tra i diversi strati di neuroni, consentendo di integrare percezione, ragionamento e azione. Se da un lato le informazioni sensoriali salgono verso l’alto per costruire rappresentazioni astratte del mondo, dall’altro lato quelle stesse rappresentazioni possono influenzare la percezione e guidare l’acquisizione di nuove informazioni rilevanti. Una dinamica che consente funzioni chiave come immaginazione, pianificazione, formulazione di ipotesi da testare. I modelli attuali? Non hanno niente di simile. Una intelligenza artificiale generale (AGI) che potrebbe emergere da qualche parte nel prossimo futuro? Forse. Chissà.

Al momento no. Alcune di queste funzionalità sono oggi ottenibili solo in modo rudimentale, “aggiungendo dall’esterno” ai modelli dei moduli ad hoc chiamati “verificatori” che ne valutano e correggono l’output. Ma è un approccio poco scalabile e lontano dall’efficienza della mente umana.

Intelligenza artificiale generale, i prossimi passi verso la meta

Nonostante questi limiti, la strada verso un’intelligenza artificiale veramente generale appare oggi più chiara e percorribile. Dal punto di vista teorico, sembra non ci siano ostacoli insormontabili: “Gli esseri umani e alcuni animali sono la prova vivente che è possibile arrivarci”, sottolinea Melanie Mitchell, professoressa al Santa Fe Institute ed esperta di AGI. La sfida è più ingegneristica e implementativa che concettuale.

I ricercatori stanno già lavorando a sistemi di IA di nuova generazione che superino i limiti di quelli attuali e incorporino caratteristiche chiave dell’intelligenza umana quali:

- Modelli del mondo più sofisticati, coerenti e adattabili per supportare ragionamento, pianificazione e generalizzazione di alto livello. Rappresentazioni simili alle nostre “simulazioni mentali” con cui immaginiamo scenari ipotetici per prendere decisioni.

- Feedback interni che consentano un flusso bidirezionale e ricorsivo di informazioni, in cui le rappresentazioni astratte possano guidare l’acquisizione di ulteriori dati rilevanti e la formulazione di esperimenti per validare le ipotesi.

- Maggiore efficienza nell’apprendimento, sviluppando la capacità di selezionare attivamente quali informazioni “assaggiare” per raffinare i propri modelli, invece di affidarsi a una massa indiscriminata di dati. Un po’ come fa un bambino che esplora attivamente il suo ambiente alla ricerca di stimoli interessanti.

- Una forma di “metamemoria”, cioè la consapevolezza di cosa si sa e non si sa, per guidare l’esplorazione e l’acquisizione mirata di nuove conoscenze.

- Strutture separate per memoria a breve e lungo termine per immagazzinare, richiamare e ricombinare rapidamente conoscenze ed esperienze pregresse, come avviene nei sistemi di memoria biologici.

- Una qualche forma di coscienza e modello di sé, per guidare comportamenti finalizzati e interazioni efficaci con l’ambiente e con altri agenti, artificiali o umani.

Su molti di questi punti si stanno facendo progressi interessanti

Yoshua Bengio sta ad esempio lavorando a nuove architetture di reti neurali, che chiama “reti di flusso generativo”, in grado di imparare simultaneamente a costruire modelli del mondo e i moduli per utilizzarli per ragionare e pianificare. Un approccio che ricorda per certi versi il funzionamento del cervello umano.

Altri ricercatori, come Jeff Hawkins di Numenta, stanno cercando di implementare nei sistemi di IA i principi della memoria biologica, con strutture separate per memoria a breve e lungo termine e processi di consolidamento e recupero delle informazioni. L’ipotesi è che possa aiutare nelle sfide di generalizzazione e ragionamento astratto.

C’è poi chi, come il neuroscienziato teorico Karl Friston dello University College di Londra, propone che una chiave per avvicinarci all’AGI sia quella di costruire sistemi che non si limitino a “ingerire” passivamente i dati di addestramento ma decidano attivamente quante e quali informazioni campionare per raggiungere i propri obiettivi. Un principio simile al “campionamento attivo” negli esseri viventi.

Le sfide etiche e di sicurezza di un’AGI

Se costruire un’intelligenza artificiale generale è teoricamente possibile, ciò non significa che sia privo di rischi o criticità. Come accennato, una super-intelligenza fuori controllo o non allineata ai valori umani potrebbe rappresentare una minaccia esistenziale per la nostra specie. Per non parlare dei possibili impatti su economia, lavoro, disuguaglianze, privacy, manipolazione dell’informazione.

Per questo motivo, ricercatori come Stuart Russell dell’Università di Berkeley sottolineano l’importanza di sviluppare fin da subito tecniche di “allineamento di valori” (value alignment) per garantire che i sistemi di AGI abbiano obiettivi e comportamenti compatibili con l’etica e il benessere umano.

Approcci promettenti in questa direzione sono quelli che mirano a far emergere comportamenti etici e valori dalla dinamica stessa di apprendimento del sistema, senza imporli dall’esterno. Una proposta interessante è quella dell’“apprendimento per rinforzo inverso collaborativo” (CIRL). Col CIRL, l’agente di IA viene premiato per aver adempiuto alle preferenze umane, ma queste preferenze stesse vengono in parte dedotte dal comportamento dell’agente e affinate nel tempo.

Altri ricercatori ritengono fondamentale che lo sviluppo dell’AGI avvenga in modo graduale. Riformulo: “stratificato”, con livelli crescenti di autonomia e abilità, in modo da poter collaudare e validare la sicurezza del sistema a ogni stadio. Un po’ come avviene nello sviluppo del cervello umano, che attraversa fasi di crescente sofisticazione dalle competenze motorie e percettive di base fino al linguaggio e alle abilità cognitive superiori.

E poi c’è ovviamente il tema della regolamentazione e governance: chi e come dovrebbe controllare lo sviluppo di tecnologie così potenti come l’AGI? Solo aziende e laboratori privati o anche governi e organizzazioni internazionali? Molti sono scettici sulla capacità degli attuali quadri normativi e istituzionali di stare al passo, e invocano una “governance globale” dell’IA ma i contorni di questa futuribile governance sono tutti da definire.

Intelligenza artificiale generale, un futuro affascinante e incerto

Tirando le fila, quanto siamo dunque vicini al traguardo di un’intelligenza artificiale generale paragonabile o superiore a quella umana? È difficile dirlo con certezza, le stime degli esperti variano da pochi anni a diversi decenni. Di sicuro c’è che i progressi degli ultimi anni hanno reso l’AGI un obiettivo molto più tangibile e hanno impresso un’accelerazione impressionante al campo.

La strada è piena di ostacoli, ma la meta non è mai sembrata così a portata di mano. E se un giorno, speriamo non troppo lontano, un’intelligenza artificiale sarà in grado di porci domande, verificare ipotesi, apprendere dall’esperienza e persino provare emozioni… allora sapremo di essere arrivati. E che il mondo, nel bene e nel male, non sarà più lo stesso.

L’articolo Intelligenza artificiale generale (AGI): ci siamo davvero vicini? è tratto da Futuro Prossimo.

Tecnologia